Platformer

Platformer En una reciente entrega de Platformer, Casey Newton nos habla de sus impresiones después de probar la beta privada de DALL-E 2, la IA de conversión de texto a imágenes de Open AI. Ojo, no confundir con DALLE mini, que ultimamente circula por twitter pero que no tiene ninguna relación con Open AI.

La conclusión de Casey tras probar la beta privada es que, tal y como los primeros ejemplos generados por el modelo prometen, DALL-E 2 va a poner patas arribas diversos sectores, como el de la ilustración y el arte visual. Que el efecto sobre estas profesiones sea positivo o nefasto es todavía una incógnita: por una parte, el modelo podría facilitar el brainstorming y la fase de ideación de proyectos de diseño e ilustración. Pero por otra parte, puede ser muy tentador para editoriales y estudios el prescindir completamente de los artistas y simplemente pagar por usar la IA e incorporar sus resultados.

“It’s natural, and appropriate, to worry about what this sort of automation might do to professional illustrators. It may well be that many jobs are lost. And yet I can’t help but think tools like DALL-E could be useful in their workflows. What if they asked DALL-E to sketch out a few concepts for them before they got started, for example?”

“It’s also worth considering what creative potential these tools might open up for people who would never think (or could afford) to hire an illustrator. As a kid I wrote my own comic books, but my illustration skills never progressed very far. What if I could have instructed DALL-E to draw all my superheroes for me instead?”

Aunque es un hecho que modelos como DALL-E son un avance revolucionario, las recientes declaraciones de este ingeniero de Google (actualmente suspendido de empleo) asegurando que uno de sus chatbots se ha vuelto consciente son, cuanto menos, dudosas.

Suponiendo que sea posible que una IA pueda llegar a ser consciente (lo cual no está nada claro), creo que todavía queda trecho para algo así, y que este asunto en concreto tiene bastante de fantasía premeditada.

Por otra parte, parece que estar escaneándonos la cara varias veces al día no es suficiente, y en Apple ya planean hasta reconocernos por nuestras venas.

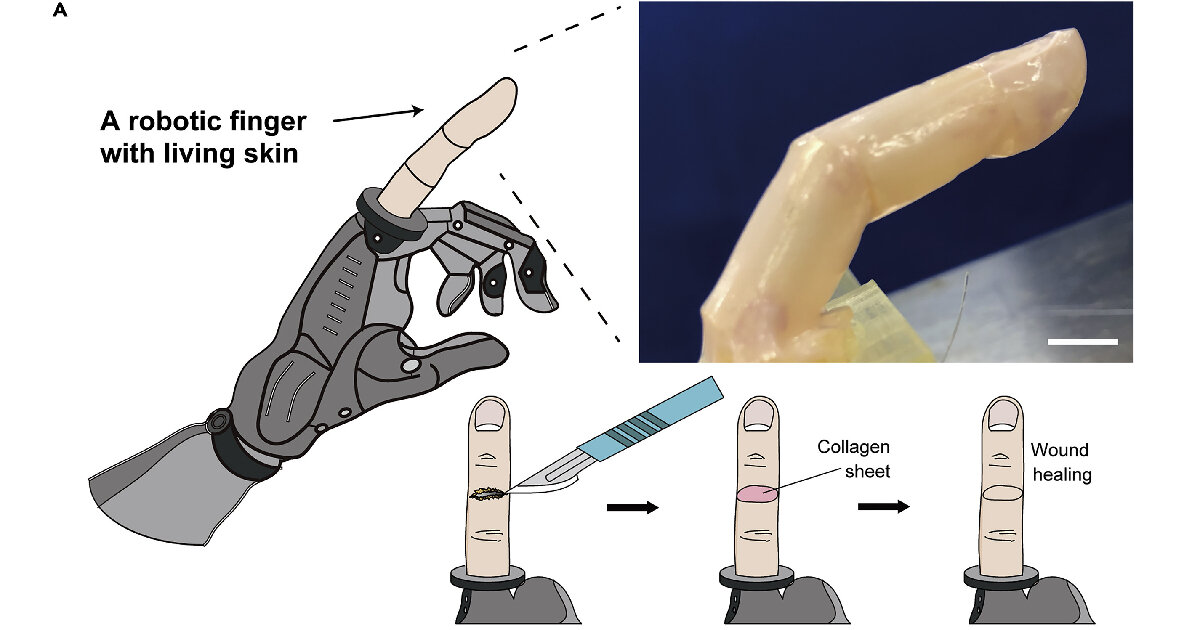

Y los robots de momento no tendrán venas, pero ya estamos un poco más cerca de que tenga algo así como “piel viva”. La investigación y prototipo de este primer dedo índice se ha producido, como no podría ser de otra manera, en la Universidad de (Neo-?)Tokyo.

En esta entrevista en podcast (cuya transcripción también se puede leer en el mismo enlace), la reportera Zoe Schiffer de The Verge apunta a aspectos clave de la ola de sindicalización que se está dando entre los empleados que ocupan los puestos menos cualificados de Amazon o Apple:

“When you look from the outside and compare Apple retail workers to other retail workers, and you’re saying, “You are paid more, the environment is a little bit better, and you get stock. What is the issue?”

Apple retail workers have really bought into this mission. Apple has made such a point of having them watch all of the large Apple events, having executives speak directly to them, and really galvanizing them about the Apple mission, that they start to compare themselves to Apple corporate. They’re saying, “Okay, you are the most profitable company in the world. You’ve had the best quarter of any company ever in terms of revenue. Why are we not seeing any of that? Why are you bringing me into the mission and telling me that I’m part of this, but then I’m not even paid a fraction of what a corporate employee makes?”

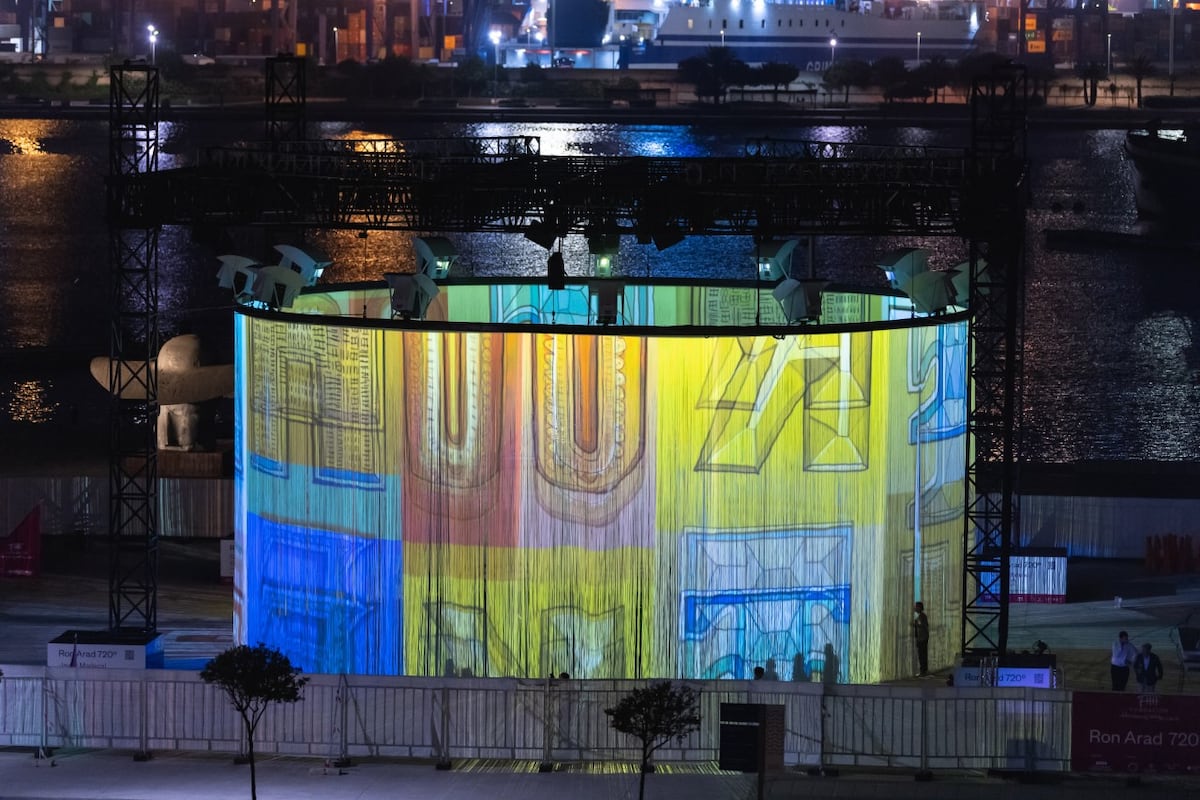

Aún no he tenido la oportunidad de acercarme a ver ésto, pero tan sólo ver las fotos nocturnas de esta cortina proyectada en 360º ya me está dando vibes cyberpunkis.

Como siempre, descubrí de carambola la música de Berried Alive, una especie de gamberrada dubstep-progresiva capaz de arrancar de guitarras eléctricas sonidos y ritmos inesperados.